模型上下文协议 x Continue

上周,Anthropic 推出了 模型上下文协议 (MCP),这是一种新的开放协议,它“使得大型语言模型(LLM)应用与外部数据源和工具之间能够无缝集成”。同样在上周,Continue 添加了对 MCP 的支持!让我们探讨一下为什么 MCP 非常适合 Continue,以及如何使用它来提升您的 AI 辅助编码体验。

完美契合:MCP 与 Continue

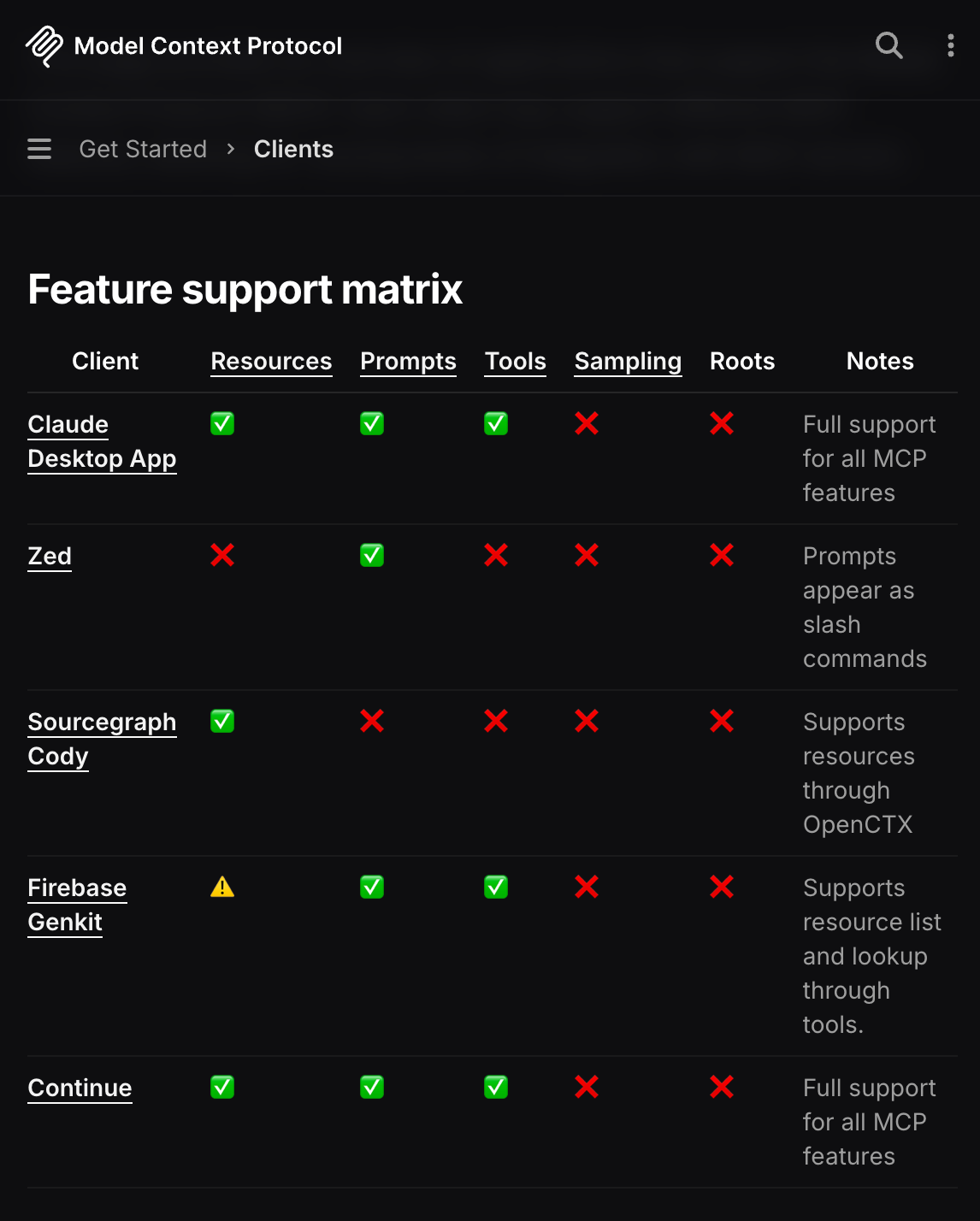

MCP 分为四个主要概念:资源(Resources)、提示(Prompts)、工具(Tools)和采样(Sampling)。这个框架与 Continue 的现有功能完美契合

开放标准和开发者拥有的工具对于塑造 AI 如何辅助开发至关重要。MCP 代表了这种社区驱动的倡议,它将帮助我们构建这个未来,赋予开发者构建和分享自定义 AI 编码助手的力量。

在 Continue 中设置 MCP

将 MCP 集成到 Continue 只需快速更新配置。首先按照其快速入门指南中的简单步骤设置本地 MCP 服务器。设置完成后,按照下面的代码片段所示,在您的 config.json 中添加 MCP 上下文提供者

{

“experimental”: {

“modelContextProtocolServer”: {

“transport”: {

“type”: “stdio”,

“command”: “uvx”,

“args”: [“mcp-server-sqlite”, “--db-path”, “/Users/NAME/test.db”]

}

}

}

}

~/.continue/config.json

在 Continue 中,只需输入“@”,从下拉列表中选择“MCP”,然后选择要获取上下文的资源。

MCP 服务器示例

Anthropic 在其 MCP servers 仓库中创建了一系列参考实现,这些实现可以直接与 Continue 一起使用。

以下是我们看到的一些最佳示例

- Google Drive:访问和搜索 Google Drive 中的文件

- Sentry:从 Sentry.io 检索和分析问题

- Puppeteer:自动化浏览器任务并执行网页抓取

- Slack:管理频道和消息

- Brave Search:使用 Brave 的搜索 API 进行网页和本地搜索

下一步是什么?

我们很高兴看到开发者社区围绕 MCP 这样的开放标准团结起来——这是迈向可互操作且强大的 AI 辅助开发工具的重要一步。随着我们进一步构建对 MCP 集成的支持,我们希望听取您的想法和意见。加入我们的 Discord 社区,分享您的经验,提出新功能建议,或与其他正在探索 AI 辅助开发未来的开发者交流。