转向并行AI:拥抱Mercury扩散语言模型

在 Continue,我们的平台建立在一个基本信念之上:开发者需要自由选择适合其特定工作流程的AI工具。正是这种理念,促使我们设计了一个开放的、模块化的架构,能够快速集成AI原生开发领域涌现的新创新。

理解扩散方法

最近,来自Inception Labs的扩散式语言模型(dLLMs)如 Mercury Coder 的引入,正是我们的架构旨在适应的技术转变类型。虽然传统的自回归模型在AI代码助手方面取得了显著进展,但由于其顺序生成方式,它们面临固有的速度限制。

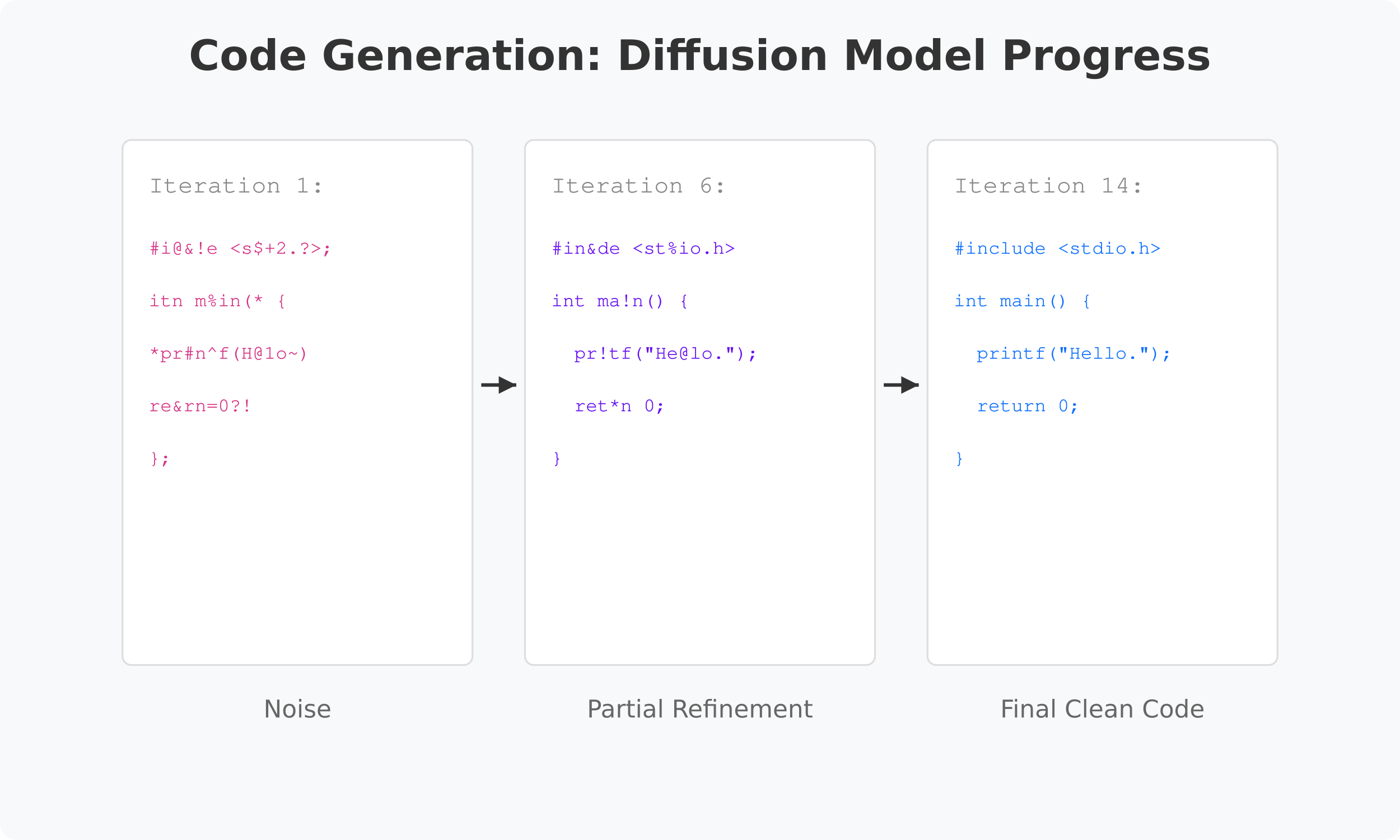

正如扩散模型可以通过迭代细化将随机噪声转化为清晰的山景图像一样,Inception Lab 的 dLLM Mercury Coder 可以并行而不是顺序地将有噪声的文本转化为干净、精确的代码。

Mercury Coder 仅需14次迭代就能将代码从噪声细化为干净实现,而传统模型需要75次以上的迭代。

保持开发者心流状态

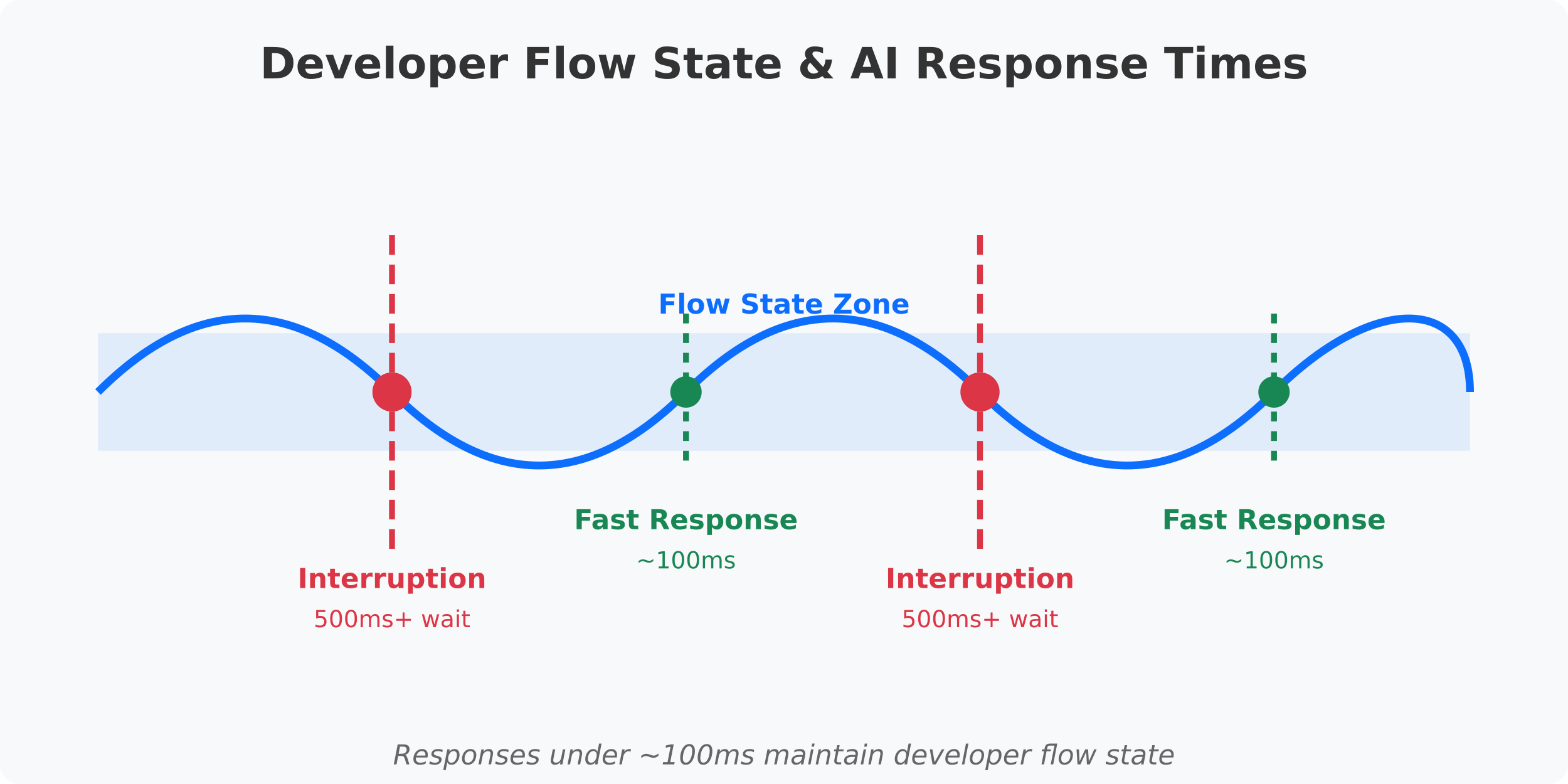

对于开发者来说,500毫秒和100毫秒响应时间之间的差异不仅仅是一个技术规范——它是保持创造性心流和不断被打断之间的差异。当你的AI助手响应时间过长时,每个建议都会变成一个上下文切换,打断你的注意力。

扩散语言模型提供的响应速度足够快,可以维持你的心流状态,而不是打断它。值得注意的是,这些模型在实现这种极快速度的同时,还能保持传统LLM的质量。

在快速发展的领域中,Continue 之所以有价值,在于我们能够快速集成涌现的新模型和新方法。与强制开发者采用单一工作方式的封闭系统不同,我们的平台允许你尝试不同的模型,并找到最能增强你独特工作流程的组合。

你的自定义AI助手,你的选择

随着AI原生生态系统持续发展,我们始终致力于提供一个平台,让开发者能够构建真正增强而不是自动化其工作的自定义助手——无论他们选择包含哪些模型或方法。

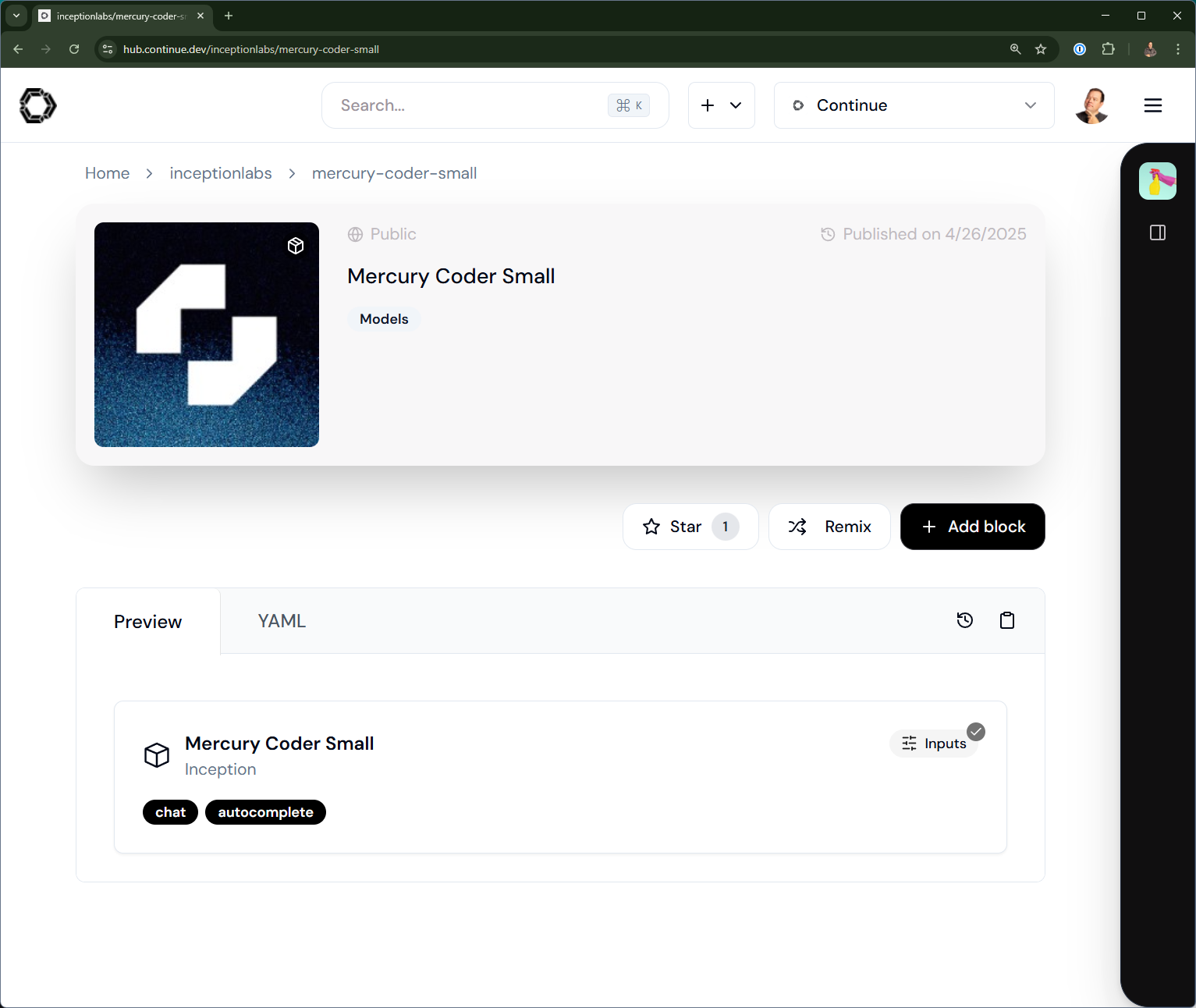

Mercury Coder 现已通过 Continue Hub 提供,并且可以轻松集成到你现有的工作流程中。

Inception 的 dLLM 只是AI代码助手中正在进行的创新之一。Continue 的模块化架构确保你能够获得这些涌现的创新,并有自由采纳最适合你特定需求和偏好的方案。

我们邀请你今天通过 Continue Hub 尝试 Mercury Coder。你可以了解更多关于如何注册 Mercury Coder的信息,亲身体验基于并行的扩散式生成如何通过超快响应改变你的开发工作流程,让你保持在创造区。

加入我们在 Discord [https://discord.com/invite/vapESyrFmJ] 的其他AI原生开发者,分享你对不同模型架构的体验,并讨论如何定制你的AI助手以获得最佳工作流程。